職場與工作技巧

擔任主管常見的 16 個挑戰與解法

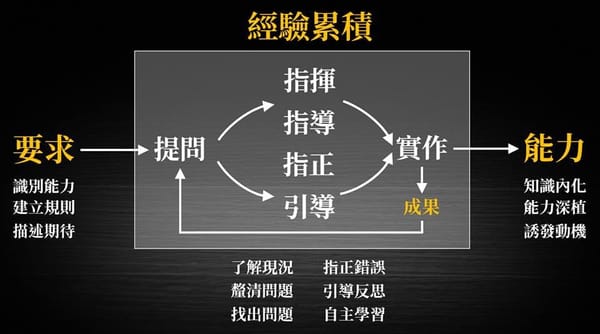

近期又有許多文章在討論,為什麼一些專業能力強的人,不願意接任主管職務,而現在的 Z 世代,願意當主管的人也愈來愈少。 或許,關鍵原因在於擔任主管職務要處理許多與專業無關,但與人有關的事,而且自己的角色會從自己做好事,轉變成讓團隊做好事,很多人在這種轉變過程難以適應,職務上的晉升到最後反成了懲罰。 我在自己超過 15 年的帶人經驗,加上這些年來在網路上、社群媒體、授課、顧問過程數千個被諮詢的管理問題,我大概彙整了擔任主管常見的 15 個挑戰與對應的解法 1. 身分轉變的挑戰 很多人從基層晉升為主管時,沒有意識到位置不同,腦袋也要跟著換。以前是一人飽全家飽,現在需要顧好整的團隊,以前可以聽指令做事,現在成了做決策的人,以前可以跟同事一起罵老闆,現在可能得站在老闆的角度跟同事溝通。 很多新手主管沒有意識到身分轉換過程,思維也該跟著調整,導致在接任前期就跌了很大一跤。 2. 空降到陌生環境,面對同事與部屬的挑戰 如果你是空降主管,在空降初期你會面對文化、環境、團隊與制度的諸多不熟悉,很多人會急著要立威,但在你缺乏人脈,也缺乏戰功的情況下,沒有人會買你的帳,甚至會有一群人正等著

![[Gipi 電子報]試刊 20241223 Vol.2](/content/images/size/w600/2024/12/Blue-Watercolor-Thank-You-Postcard--2-.png)